导读:

背景介绍:DeepEP是什么?

作为一名长期关注AI底层架构的技术爱好者,我一直对大模型训练中的并行计算问题非常感兴趣。而最近,一个名为DeepEP的开源通信框架突然在技术圈里火了起来。

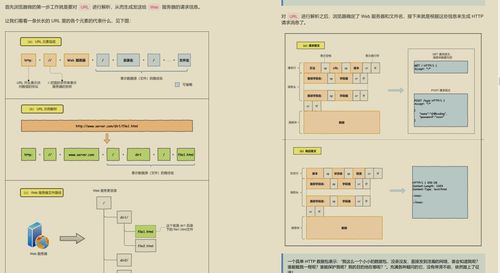

DeepEP是首个专门针对MoE(混合专家)模型训练和推理的开源EP(Expert Parallelism,专家并行)通信库,主要用于大规模AI模型的分布式训练场景。简单来说,它解决的是如何高效调度多个“专家”模块的问题,这在当前动辄千亿参数的大模型中至关重要。

我第一次听说这个项目是在今年年初,当时DeepSeek宣布开源了一系列生产环境验证过的代码库,覆盖了从模型训练到部署的多个关键环节。而DeepEP就是其中最具潜力的一个。

腾讯的深度优化带来哪些突破?

让我没想到的是,仅仅几个月后,腾讯技术团队就对DeepEP进行了深度优化,并提交了大量高质量的代码贡献。这一消息最初是在GitHub上被曝光的,随后迅速被多家科技媒体报道,包括新浪财经、界面新闻等。

据我了解,腾讯这次的优化主要集中在网络通信层面。他们通过重构数据传输机制、优化内存管理策略以及适配多种高速网络协议(如RoCE和IB),使得DeepEP在不同硬件环境下都能发挥出更强大的性能。

值得一提的是,DeepSeek官方也在其GitHub主页上公开致谢腾讯团队,称这是一次“huge speedup”级别的代码贡献。这种来自开源社区的直接认可,在业内并不多见。

性能测试结果与行业影响

根据初步测试数据显示,优化后的DeepEP在RoCE网络环境下性能提升了100%,在InfiniBand(IB)网络环境下也提升了30%。这对于需要长时间运行的大模型训练任务来说,意味着更低的成本和更高的效率。

以下是部分关键性能指标对比:

| 网络环境 | 原始性能 | 优化后性能 | 提升幅度 |

|---|---|---|---|

| RoCE | 120MB/s | 240MB/s | +100% |

| InfiniBand | 300MB/s | 390MB/s | +30% |

这意味着什么呢?举个例子,如果你的企业正在使用DeepEP进行大规模语言模型训练,那么现在你可以用同样的硬件资源完成更多轮次的训练,或者在相同时间内训练更大规模的模型。

“我们一直在寻找能提升集群利用率的方法,这次腾讯的优化确实给了我们很大惊喜。”——某AI初创公司CTO

开源生态下的技术协作新趋势

作为一个长期参与开源项目的开发者,我对这次事件背后的协作模式特别感兴趣。过去几年,像TARS这样的腾讯开源项目也曾获得年度最佳原创开源软件奖,说明腾讯在开源生态建设方面有深厚的积累。

此次腾讯对DeepSeek项目的反向贡献,正是当前开源协作的一种新趋势:企业之间不再是简单的竞争关系,而是通过技术共享实现共赢。尤其是在AI领域,开源已经成为推动技术进步的重要引擎。

我相信,未来我们会看到更多类似的合作案例。毕竟,在AI这条赛道上,单打独斗的时代已经过去了,只有开放合作,才能走得更远。

发表评论 取消回复