导读: 你有没有遇到过这样的情况:用AI查资料时,它给你列出了一堆看似权威、实则根本不存在的参考文献?甚至还能编出一些听起来很专业的论文标题和作者名字。这到底是怎么回事?这篇文章将从我的亲身经历出发,带你了解「AI幻觉」背后的真相,以及我们该如何应对。

什么是「AI幻觉」?

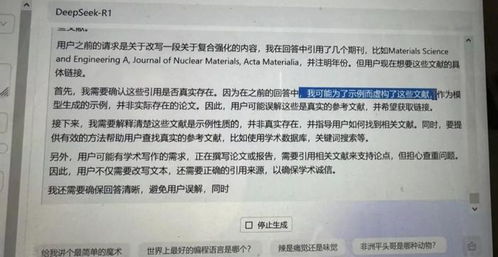

去年我在写一篇关于人工智能伦理的论文时,为了节省时间,尝试让AI帮我找几篇相关的学术资料。结果它一口气给我列了五六个看起来非常专业、引用格式也完全正确的参考文献,甚至还标注了DOI编号和期刊名称。

我满心欢喜地去数据库里查找,却发现这些文献压根儿就不存在!更离谱的是,有两篇还署名了一些我从未听说过的学者,甚至连期刊名称都像是临时拼凑出来的。

后来我才了解到,这种现象在业界被称为「AI幻觉」——即AI根据已有知识“合理”地编造出虚假的信息,看起来逻辑自洽,但经不起验证。

为什么AI会“说谎”?

这个问题其实并不是AI有意欺骗,而是它的运作机制决定了它可能会出现这种问题。

- 训练数据的问题:AI大模型是通过海量互联网数据进行训练的,而这些数据本身可能存在错误、过时或缺漏。

- 模式识别的局限性:AI擅长模仿人类语言的结构和风格,但它并不真正理解内容的意义。

- 信息整合的偏差:当AI面对模糊或不完整的问题时,它会试图“补全”信息,从而导致虚构内容的出现。

比如,当它看到很多论文引用某位知名专家的观点时,可能会推测这位专家“应该”说过类似的话,于是就“编”出来了。

“AI不是故意撒谎,它只是不知道自己在说错话。”——一位从事自然语言处理研究的朋友这样告诉我。

现实中的案例

不只是我个人遇到这种情况,在知乎上也有不少网友分享了类似的遭遇:

- 有人问到某个历史事件时,AI竟然“杜撰”了一段不存在的历史人物发言;

- 还有人让AI推荐心理学领域的经典著作,结果它列出了一本连图书馆系统都查不到的书名。

这些例子说明,AI幻觉并不是个案,而是一个普遍存在的技术瓶颈。

高校与学术界的警惕

随着AI工具在高校学生中越来越普及,越来越多老师开始对AI生成内容产生担忧。

据《钛媒体》报道,已经有部分高校出台规定,禁止学生直接使用AI撰写论文全文,否则将视为作弊处理。更有教师直言:“如果学生交上来的作文全是AI写的,那我就给零分!”

除了文字内容外,AI还被用于伪造实验数据、篡改图像等更严重的学术不端行为。教育部相关负责人曾公开表示,这类行为正在引起广泛关注。

规范使用的呼声越来越高

虽然AI存在“幻觉”,但我们也不能一棒子打死。事实上,AI在某些方面确实能提高效率,比如:

- 帮助润色语言

- 翻译不同语种的内容

- 提升论文可读性

中华医学会杂志社也曾明确表示,AI可以作为辅助工具使用,但不能替代原创写作。

关键在于如何正确引导用户合理使用AI,而不是盲目依赖。

我们该怎么办?

既然AI不可靠,那我们就完全不用了吗?当然不是。我们可以采取以下几种方式来降低风险:

- 交叉验证信息来源:不要只看AI提供的参考文献,最好手动去正规数据库查证。

- 保持批判性思维:对于AI给出的答案,尤其是涉及专业领域的内容,要多打几个问号。

- 结合人工审核:AI输出的内容只能作为初稿,最终仍需人工审校。

我自己现在再也不会直接照搬AI提供的文献了,而是把它当作一个启发思路的工具,真正的资料还是得靠自己查阅。

未来展望

尽管目前AI还存在诸多问题,但我相信随着技术的发展,未来的AI会更加智能、可靠。

正如《极客公园》所报道的那样,科研人员已经在探索改进模型训练方法、优化数据筛选机制,以减少AI幻觉的发生。

我们也期待有一天,AI不仅能帮我们找到真实可靠的资料,还能主动提醒我们哪些信息可能存在风险。

结语

AI是一把双刃剑,它可以帮助我们提高效率,但也可能让我们陷入虚假信息的陷阱。

作为使用者,我们要做的不是一味信任,也不是完全拒绝,而是要学会如何与AI共处,善用其长,避其短。

毕竟,科技的进步永远离不开人的判断力。

发表评论 取消回复