导读:

一、一场意外的测试引发的思考

前几天,我在测试几款主流大模型时,遇到了一件让我哭笑不得的事情。原本只是想看看它们在连续对话中的表现,结果却发现——一旦走偏了一步,后续怎么引导都没用!就像是一个打瞌睡的人,你怎么叫都叫不醒。

这让我想起了最近在36氪看到的一篇报道,里面提到一个新词:「对话迷失」。研究人员发现,当大模型在多轮对话中走错了方向,即使后续提示中添加再多信息也无法纠正,导致整个对话路径彻底崩盘。

二、什么是「对话迷失」?

“语言模型的世界里没有‘真假’,只有‘可能性’。”

这句话来自钛媒体的一篇深度分析文章,讲的就是AI幻觉的问题。而「对话迷失」可以说是AI幻觉的一种延伸表现形式。

简单来说,就是大模型在处理复杂任务或连续提问时,一旦某个环节理解错误,就会像滚雪球一样越错越大,最终完全偏离用户的意图,甚至给出荒谬的答案。

三、我的实测结果:五款大模型的表现如何?

为了验证这个现象,我选取了市面上比较热门的五款大模型进行对比测试:

- 通义千问(Qwen)

- DeepSeek

- 阶跃星辰Step-1

- 百度文心一言

- 腾讯混元

测试方式很简单:我先提出一个基础问题,然后逐步引导它深入解答,中间故意插入一个误导性的问题,再回到原题。

结果令人震惊:除了DeepSeek外,其余四款模型几乎都在第三轮之后开始跑偏,有的甚至直接放弃回答。

四、为什么会这样?技术背后的逻辑是什么?

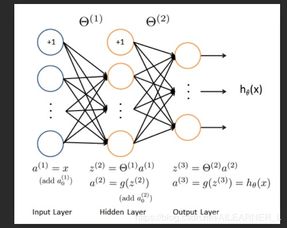

根据虎嗅APP之前的一篇文章,目前主流的LLM架构在设计上更倾向于单token预测,而不是整体语义理解。

这就意味着,模型在处理每一步的时候,并不会真正记住前面的所有上下文,而是基于当前输入和部分历史记录做出判断。

举个例子:就像你在看一部剧,但只记得上一集的最后几分钟,其他情节靠模糊记忆拼凑。这种情况下,自然容易出现逻辑断裂。

五、未来趋势:小模型与大模型的协作是否是出路?

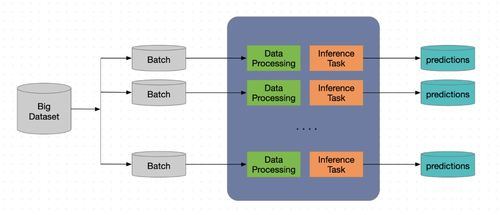

不过好消息是,一些新兴技术正在尝试解决这个问题。比如SpecReason提出的反思投机算法,就利用小模型生成初步的推理链,再由大模型进行验证。

这种方法不仅提高了准确性,还显著降低了算力消耗。毕竟现在大模型的成本已经让很多企业望而却步了。

正如蚂蚁百灵大模型负责人周俊所说:“在你不了解你的数据时,不要对数据做更多的假设,让模型去接管更多的东西。”

总的来说,虽然目前大模型在多轮对话中还存在明显的短板,但随着技术的不断进步,我相信这一问题终将被解决。

如果你也遇到过类似的情况,欢迎留言分享你的体验,我们一起探讨大模型的未来之路。

发表评论 取消回复