在简书平台上,关于“MySQL生成千万级数据”的话题引发了广泛关注。作为一名技术爱好者,他决定深入研究这一问题,并通过自己的实践为大家分享经验。

首先,他明确了一个关键点:生成大规模数据并不是为了炫耀技术,而是为了测试系统性能、优化数据库结构以及提升开发效率。带着这样的目标,他开始了探索之旅。

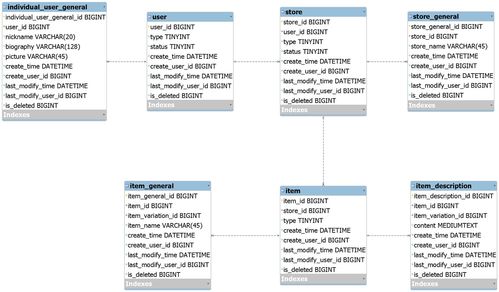

一、需求分析与背景

随着互联网业务的快速发展,数据库承载的数据量越来越大。对于开发者而言,模拟真实环境中的海量数据变得尤为重要。于是,他意识到,掌握一种高效的方法来生成千万级数据是一项必备技能。

二、方案选择

在实际操作前,他调研了多种方法。例如使用循环插入语句、存储过程以及外部工具等。经过反复对比,他最终选择了结合MySQL存储过程的方式,因为这种方式不仅简单易用,而且能够显著提高插入效率。

以下是他的具体实现步骤:

- 创建一张测试表,定义好字段类型和索引;

- 编写一个存储过程,利用循环结构批量插入数据;

- 调用该存储过程并设置参数,控制生成数据的数量。

三、代码示例

-- 创建测试表

CREATE TABLE test_data (

id INT AUTO_INCREMENT PRIMARY KEY,

name VARCHAR(50),

age INT,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP

);

-- 编写存储过程

DELIMITER $$

CREATE PROCEDURE generate_large_data(IN num INT)

BEGIN

DECLARE i INT DEFAULT 1;

WHILE i <= num DO

INSERT INTO test_data (name, age) VALUES (CONCAT('User', i), FLOOR(RAND() * 50 + 1));

SET i = i + 1;

END WHILE;

END$$

DELIMITER ;

-- 调用存储过程

CALL generate_large_data(10000000);通过上述代码,他成功地生成了包含千万条记录的数据集。整个过程耗时较短,充分证明了存储过程的高效性。

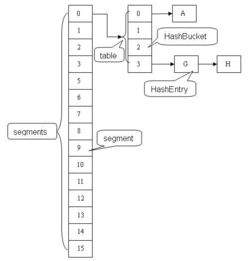

四、性能优化技巧

尽管存储过程表现优异,但在处理超大规模数据时仍需注意以下几点:

- 禁用唯一索引或主键约束(如果允许),以减少插入时的开销;

- 调整MySQL配置文件中的innodb_buffer_pool_size参数,增加内存缓存容量;

- 分批次插入数据,避免单次事务过大导致锁表问题。

五、总结与展望

通过这次实践,他对MySQL的性能有了更深刻的理解。同时,他也发现,在面对复杂场景时,灵活运用各种工具和技术至关重要。未来,他计划继续深入学习数据库相关知识,为解决更多实际问题贡献自己的力量。

发表评论 取消回复