在人工智能模型的激烈竞争中,DeepSeek-R1 的更新再次掀起波澜。这次发布的 DeepSeek-R1-0528 版本,不仅让模型的思考深度和推理能力有了显著提升,甚至在某些指标上接近了 OpenAI 最新的 o3 模型。

文章导读

- DeepSeek-R1-0528 是什么?

- 技术突破:GRPO 算法如何改变游戏规则

- 开源战略:MIT 协议背后的生态野心

- 性能飞跃:H100 上的 26 倍提速

- 社会影响:点燃研究社区的热情

- 未来展望:递归 + 强化学习的无限可能

DeepSeek-R1-0528 是什么?

DeepSeek-R1-0528 是 DeepSeek 官方近期推出的更新版本,作为 R1 系列的迭代产品,它在原有基础上进一步优化了模型的推理能力和思维深度。据官方介绍,该版本已经能够在多个复杂任务中表现出接近 o3 的水平。

这不仅是一次简单的升级,而是一场关于LLM 推理方式的深刻变革。

技术突破:GRPO 算法如何改变游戏规则

“DeepSeek-R1 的真正秘籍在于 GRPO 算法。”——来自新智元的技术分析

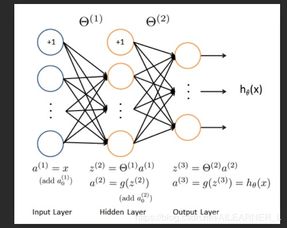

在众多技术亮点中,最引人注目的莫过于其采用的强化学习微调算法:群体相对策略优化(Group Relative Policy Optimization, GRPO)。

这项技术的核心在于:

- 通过多候选方案自动选择最优解

- 无需大量标注数据即可训练出高性能推理模型

- 显著提升模型泛化能力,适应新问题的能力更强

这也解释了为何 DeepSeek-R1-Zero 能在没有监督微调的情况下,依然能与 o1 相媲美。

开源战略:MIT 协议背后的生态野心

DeepSeek 选择了 MIT 协议 进行开源,这一宽松协议与千问系列的 Apache2.0 协议遥相呼应,在 OpenAI 闭源垄断的大环境下,国产大模型正试图用开放姿态构建全球开发者生态。

这种策略不仅吸引了大量开发者参与,也为未来的模型演进铺平了道路。

性能飞跃:H100 上的 26 倍提速

根据 SGLang 和英伟达联合团队的技术报告,他们在短短四个月内就实现了 DeepSeek-R1 在 H100 上性能提升了 26 倍,吞吐量几乎达到官方数据标准。

这意味着什么?

- 更高效的部署

- 更低的成本

- 更快的响应速度

这一切都让 DeepSeek-R1 成为了当前 LLM 领域最具性价比的选择之一。

社会影响:点燃研究社区的热情

DeepSeek-R1 自发布以来,已经在学术界和技术圈引发了广泛关注。尤其是在数学定理证明、逻辑推理等高阶任务中,它的表现令人惊艳。

网友评价说:“这可能是迈向超越人类智能的关键一步!”

未来展望:递归 + 强化学习的无限可能

DeepSeek-Prover-V2 的训练核心正是基于 递归 + 强化学习 的组合拳。DeepSeek-V3 先将复杂定理拆解为子目标,再由 GRPO 算法从中挑选最优路径。

这种机制不仅提高了推理效率,也让模型具备了更强的自主学习能力。

未来,我们或许会看到更多基于这种架构的 AI 模型出现,甚至可能催生出真正意义上的“数字科学家”。

结语:DeepSeek-R1-0528 的发布不仅是技术上的进步,更是对整个 LLM 生态的一次重新定义。从 GRPO 到 MIT 开源,从 H100 性能优化到递归推理探索,每一步都在推动着 AI 向更高层次迈进。

发表评论 取消回复