最近,全球AI领域掀起了一股热潮,而这场风暴的核心正是来自中国的DeepSeek。作为一名对AI技术充满热情的技术爱好者,我有幸深入研究了DeepSeek刚刚开源的FlashMLA,并发现了一些令人惊叹的技术细节。

一、中美大模型技术差距的重新审视

一直以来,关于中美在大模型领域的技术差距问题备受关注。然而,这次DeepSeek的表现无疑让整个行业为之侧目。他们通过采用混合专家模型(MoE)架构,成功将计算成本降至传统模型的十分之一。这种“烧脑改算法”的策略不仅展示了DeepSeek团队的技术实力,也让人们看到了中国在AI领域的崛起。

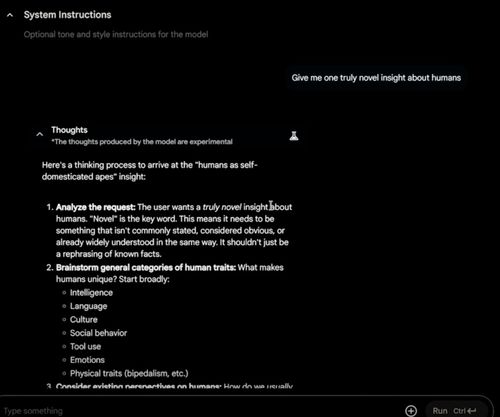

二、FlashMLA的核心技术亮点

1. 多头潜在注意力机制(MLA)

FlashMLA的最大亮点之一是其多头潜在注意力机制(Multi-head Latent Attention, MLA)。这项技术通过低秩分解的方式优化KV-Cache,大幅降低了存储和计算需求。简单来说,就是将原本复杂的多维矩阵压缩成一维矩阵,从而实现性能与效率的双重提升。

2. 动态冗余策略

DeepSeek在模型设计中引入了动态冗余策略,这一创新使得模型能够在保证准确性的前提下,显著减少计算资源的消耗。这种方法不仅可以降低硬件成本,还为大规模部署提供了更多可能性。

3. 模型蒸馏与算力调度

除了上述核心技术外,DeepSeek还在模型蒸馏和算力调度方面展现了卓越的能力。通过高效的模型蒸馏技术,FlashMLA能够以更小的体积保留原模型的主要特性,同时进一步优化推理速度。此外,算力调度的优化也确保了模型在不同硬件环境下的稳定表现。

三、开源策略的影响与意义

DeepSeek选择将FlashMLA开源,这一举动犹如一颗震撼弹,打破了长期以来由少数巨头主导的AI技术格局。如今,这项技术已经向全世界敞开大门,任何开发者都可以免费获取并使用。这不仅促进了技术的普及,也为其他公司带来了巨大的竞争压力,迫使它们调整价格策略以保持市场地位。

四、未来的可能性与挑战

尽管FlashMLA展现出了巨大的潜力,但DeepSeek仍然面临着不少挑战。例如,如何进一步优化模型性能,以及如何在实际应用场景中验证其有效性等问题,都需要持续探索和解决。不过,可以预见的是,随着更多开发者加入到这个开源项目中,FlashMLA的技术生态将会愈发完善。

总的来说,DeepSeek开源的FlashMLA不仅是一项技术创新,更是对中国乃至全球AI行业发展的重要推动。作为一名技术爱好者,我对DeepSeek的未来发展充满期待,相信他们会带来更多惊喜。

发表评论 取消回复