在AI领域,一场技术革命正在悄然展开。今天,我们聚焦于一个令人振奋的突破——由斯坦福、UC伯克利和华盛顿大学等顶尖机构联合发布的全新开源推理模型OpenThinker-32B。这一模型不仅性能直逼DeepSeek-R1-32B,还成功超越了李飞飞团队的s1-32B。

背景:从数据到模型

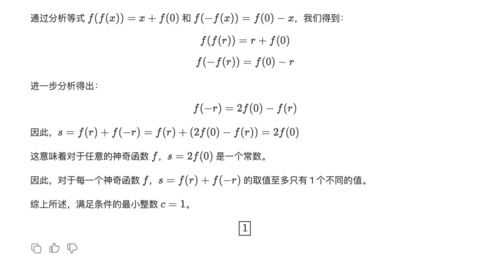

让我们先回顾一下这场技术竞赛的起点。几个月前,DeepSeek发布了其最新的开源推理模型DeepSeek-R1-32B,在多个基准测试中表现卓越,尤其是在数学推理、代码生成和自然语言理解方面,几乎与OpenAI的o1系列持平。然而,就在全球还在为DeepSeek的成就欢呼时,李飞飞团队却以不到50美元的云计算费用训练出了s1-32B,这款模型以其高效性和低成本引起了广泛关注。

然而,故事并未就此结束。近日,来自斯坦福、UC伯克利和华盛顿大学的研究团队联手推出了一款名为OpenThinker-32B的新模型,再次刷新了开源推理模型的性能记录。

揭秘OpenThinker-32B的成功秘诀

那么,OpenThinker-32B是如何做到这一点的呢?答案在于三个关键因素:数据规模化、严格验证和模型扩展。

- 数据规模化:OpenThinker-32B使用了一个高达114k的高质量训练数据集,这些数据经过深度标注和验证,确保了模型的学习质量。

- 严格验证:在训练过程中,团队采用了基于DeepSeek-R1蒸馏的技术,对模型的推理过程进行了全面验证,从而提高了模型的稳定性和准确性。

- 模型扩展:通过扩展模型规模至32B参数,OpenThinker-32B在处理复杂任务时表现出色,甚至能够在仅使用1/8数据的情况下与同尺寸的DeepSeek-R1打成平手。

实际应用与未来展望

OpenThinker-32B的发布不仅仅是一个技术里程碑,更是一次对开源社区的重大贡献。这款模型的开源性质意味着更多的研究者和开发者可以利用它进行进一步的研究和创新。例如,在医疗诊断、法律咨询和金融分析等领域,OpenThinker-32B的推理能力将带来显著的效率提升。

此外,随着AI技术的不断进步,我们可以预见未来的推理模型将更加智能化和个性化。无论是解决复杂的科学问题,还是帮助普通人完成日常任务,AI都将扮演越来越重要的角色。

总结

从DeepSeek-R1-32B到李飞飞的s1-32B,再到如今的OpenThinker-32B,每一次技术突破都标志着AI领域的快速发展。作为普通用户,我们有理由期待更多令人惊叹的成果出现。而作为开发者,我们也应积极参与到这场技术革命中,共同推动AI技术的进步。

发表评论 取消回复