导读: 一句话生成任务专属LoRA | Transformer作者的又一次突破 | 为何这项技术如此重要? | 未来将如何发展?

一句话生成任务专属LoRA:AI微调的新纪元

最近,36氪上一则关于“一句话生成任务专属LoRA”的消息引发了广泛关注。这并非空穴来风,而是源自一家由Transformer论文核心作者创立的初创公司——他们正在用一种全新的方式重新定义大语言模型(LLM)的微调。

简单来说,这家创业公司提出了一种基于低秩适应(Low-Rank Adaptation, 简称LoRA)的技术,可以仅凭一句自然语言指令,就能快速为特定任务生成定制化的微调模型。这意味着,过去需要大量数据和算力才能完成的模型优化过程,现在只需输入一句话,即可完成。

从Transformer到LoRA:一场持续进化的AI革命

提到Transformer架构,很多人第一时间会想到它在NLP领域的巨大影响力。而它的几位原始作者之一,正是这次创业公司的核心人物。他们在Google Brain时期就奠定了Transformer的基础,如今又带着新的理念回归,试图解决当前大模型应用中的一大痛点:模型微调成本过高。

传统的模型微调通常需要大量的训练数据、昂贵的计算资源以及漫长的训练时间。这对于中小企业和独立开发者而言,无疑是一道难以逾越的门槛。而LoRA技术的出现,让这一切变得轻量且高效。

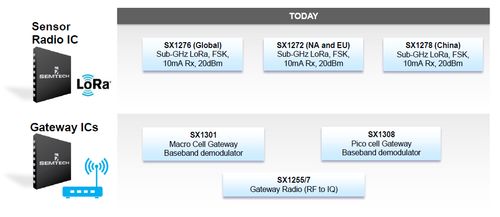

LoRA的核心思想是通过在原始模型权重矩阵中引入一个低秩矩阵,从而实现对模型的小规模调整。这种调整不仅节省了大量参数空间,还能保持原有模型性能的同时,快速适配新任务。

一句话生成LoRA的意义:谁将受益?

这项技术的最大亮点在于其极高的灵活性和可扩展性。想象一下,你只需要告诉系统:“我需要一个能自动撰写产品描述的AI助手”,系统就能立即为你生成一个高度定制化的微调版本,而无需任何额外的数据标注或训练过程。

这对于以下几类用户群体尤为关键:

- 中小型企业:无需投入大量资金与人力,即可拥有属于自己的定制化AI模型。

- 开发者与创业者:快速迭代、快速验证,大大缩短产品上线周期。

- 教育与科研机构:便于教学演示、实验研究,降低学习门槛。

更重要的是,这种“一句话生成”的能力,意味着未来可能不再需要专业的机器学习工程师来操作模型微调,普通用户也能轻松上手。

未来展望:从LoRA到更智能的AI交互

目前,这项技术还处于早期阶段,但已经展现出巨大的潜力。随着更多实际场景的应用落地,我们或许将迎来一个“人人皆可微调”的时代。

一些行业观察人士认为,未来的AI平台可能会像现在的App Store一样,提供各种基于LoRA的任务插件,用户只需一句话,就能下载并部署一个专属于自己的AI助手。

“这不仅是技术的进步,更是AI民主化进程的重要一步。”

对于整个AI生态而言,这无疑是一个里程碑式的进展。它不仅降低了使用门槛,也极大地提升了模型的个性化能力,为AI真正走向大众铺平了道路。

发表评论 取消回复