导读:你有没有想过,一个大模型的推理引擎,竟然能在短短时间内被一位研究员用不到2000行代码重新实现?而且,更令人惊讶的是,在H800硬件上运行的性能还超过了原版。这背后到底发生了什么?让我们一起揭开这场AI技术风暴背后的秘密。

一、一场关于效率与创新的技术挑战

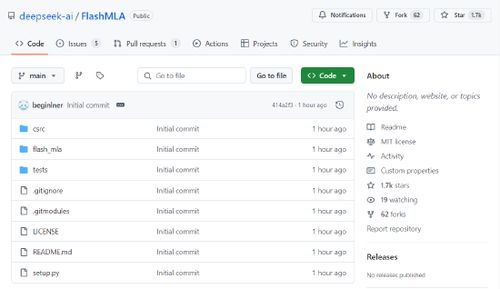

最近,DeepSeek 的一名研究人员在 GitHub 上开源了一个名为 FlashMLA 的项目,该项目仅用了 1200 行 C++ 和 CUDA 代码 就成功复刻了 vLLM 的核心功能,并在 H800 硬件平台上实现了超越原版的推理速度。

“我们并没有使用任何复杂的框架,只是专注于优化注意力机制和内存管理。”——该研究员在一次内部分享会上如是说。

这个项目的开源地址为:https://github.com/deepseek-ai/FlashMLA,目前已获得大量 Star 和 Fork,社区反响热烈。

二、技术亮点:从架构设计到极致优化

FlashMLA 的核心在于其对多头注意力机制(MLA)的高效实现。通过引入一种新的解码内核,它特别针对 NVIDIA Hopper 架构(如 H800)进行了深度优化。

- 可变长度序列支持:相比传统方法,FlashMLA 能更灵活地处理不同长度的输入序列,显著提升吞吐量。

- 内存访问优化:通过减少 GPU 显存访问次数,降低了延迟并提升了整体性能。

- 轻量化设计:整个项目没有依赖任何大型框架(如 Ray、DeepSpeed),完全从零构建,代码结构清晰易懂。

三、实测数据:H800 上的惊人表现

在实际测试中,FlashMLA 在 H800 SXM5 平台上表现出色:

| 配置类型 | 内存带宽 | 计算峰值 |

| 内存受限 | 最高可达 3000GB/s | N/A |

| 计算受限 | N/A | 峰值可达 580 TFLOPS |

这些数据表明,FlashMLA 不仅能充分利用硬件资源,还能在成本控制方面带来显著优势。

四、DeepSeek 的战略意义

这一技术突破不仅体现了 DeepSeek 在软硬件协同设计方面的深厚积累,也进一步巩固了其在大语言模型领域的领先地位。

- 小团队也能做大事:FlashMLA 的成功证明,即使是小规模团队,只要具备扎实的技术能力和创新思维,也能在 AI 领域取得重大突破。

- 推动行业开放生态:通过开源 FlashMLA,DeepSeek 正在鼓励更多开发者参与进来,共同推动大模型技术的发展。

- 降低训练成本:FlashMLA 的高效性意味着更低的训练和推理成本,这对中小企业和研究机构来说无疑是一大福音。

五、未来展望:R2 版本即将上线?

根据 DeepSeek 一贯的产品发布节奏,基础模型推出后几周内通常会发布专门的推理增强版本。因此,有理由相信,DeepSeek-R2 很可能将在不久之后正式上线。

R2 版本预计将重点提升以下能力:

- 更强的数学推理能力

- 更高的代码生成准确率

- 更高效的上下文理解能力

六、结语:AI 技术的平民化时代正在来临

从 FlashMLA 到 DeepSeek-V3,再到即将发布的 R2,DeepSeek 正在用实际行动告诉我们:AI 技术不再是巨头的专属,而是每一个开发者都可以参与的舞台。

如果你也想参与到这场技术革命中来,不妨去 GitHub 上看看 FlashMLA 的源码,也许下一个改变世界的灵感就藏在你的指尖。

发表评论 取消回复