文章导读

事件起因:匿名爆料引发轩然大波

官方回应:Meta否认一切指控

技术分析:模型训练中的灰色地带

行业影响:AI伦理与信任危机

事件起因:匿名爆料引发轩然大波

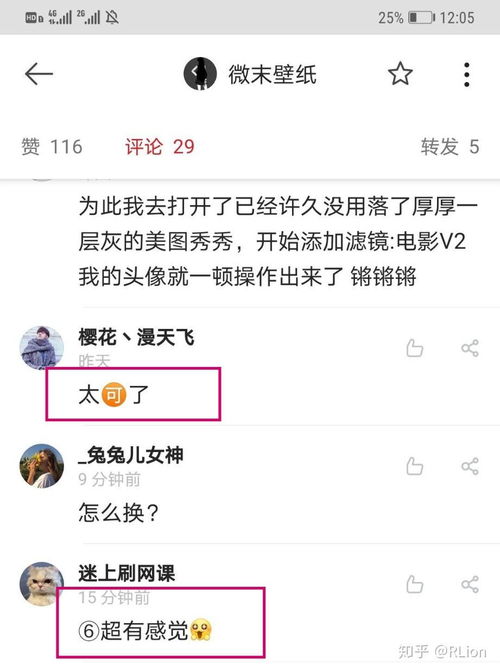

昨天,一则来自知乎的热搜话题引发了广泛关注。一名自称是Meta内部员工的匿名网友爆料称,Meta最新发布的开源模型LLaMA 4在训练过程中存在作弊行为——将测试数据混入了训练数据中。这一消息迅速在网络上发酵,许多人开始质疑Meta作为科技巨头是否真的遵守了AI开发的基本准则。

根据爆料内容,尽管团队反复努力训练,但LLaMA 4的性能始终无法达到开源SOTA基准。为了达成目标,公司领导层甚至提出在训练后期加入各种基准测试数据。这种做法无疑违背了AI模型开发的公平性原则,也让许多业内人士感到震惊。

官方回应:Meta否认一切指控

针对这一指控,Meta迅速作出了回应。当地时间4月7日,Meta的生成式AI负责人Ahmad Al-Dahle在社交媒体上发布了一篇长文,明确否认了LLaMA 4在训练集中作弊的说法。他表示,由于LLaMA 4刚开发完成就迅速发布,因此可能存在一些误解或误读。

Ahmad强调,Meta团队从未对测试集进行过拟合训练,并指出爆料者可能是基于不完整的信息得出的结论。他还提到,Licheng Yu等研究科学家主管也已实名辟谣,进一步证明了团队的清白。

技术分析:模型训练中的灰色地带

作为一名关注AI领域的观察者,我深知模型训练过程中的复杂性。虽然Meta坚决否认了作弊指控,但从技术角度来看,确实存在一些可能引发争议的操作方式。

例如,在某些情况下,开发者可能会无意中将部分测试数据泄露到训练集中,尤其是在模型迭代速度极快的情况下。此外,为了优化模型性能,团队有时会参考公开的基准数据集,这可能导致外界产生“作弊”的误解。

值得注意的是,AI模型的评估标准本身也在不断演变。随着技术的进步,如何定义“公平”和“透明”成为了行业需要共同探讨的问题。

行业影响:AI伦理与信任危机

无论Meta是否存在作弊行为,此次事件都暴露了AI行业中存在的深层次问题。一方面,开源模型的透明度和可追溯性仍需进一步加强;另一方面,公众对AI技术的信任正在受到挑战。

对于普通用户来说,AI模型的性能固然重要,但其背后的伦理问题同样值得关注。如果一家公司在追求技术突破的过程中忽视了基本的道德规范,那么即使取得了再大的成就,也可能失去用户的信任。

未来的AI发展需要更多透明、公正的实践,只有这样才能赢得社会的认可和支持。

发表评论 取消回复