在大数据处理领域,Flink作为一款强大的流处理框架,其与Kafka的结合无疑是开发者们关注的焦点之一。作为一名技术爱好者,在研究Flink KafkaSource源码的过程中,我深刻体会到了这一模块背后的设计精妙与复杂性。今天,就让我们一起走进Flink KafkaSource的世界,揭开它的神秘面纱。

一、初识Flink KafkaSource

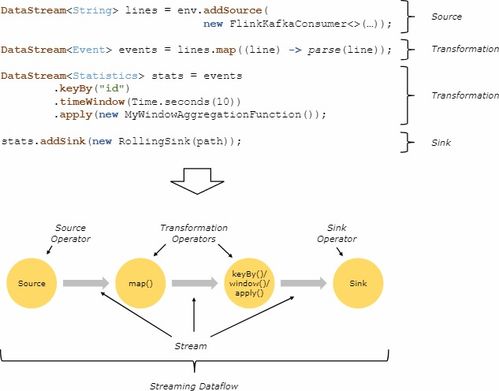

Flink KafkaSource是Flink中用于连接Kafka数据源的核心组件。它负责从Kafka集群中拉取数据,并将其转化为Flink可以处理的数据流。对于初学者来说,理解KafkaSource的工作原理和实现细节是非常重要的。通过阅读官方文档和源码,我发现KafkaSource的设计充分考虑了性能优化与容错能力,这使得它能够胜任各种复杂的生产环境。

二、源码解析:一步步拆解KafkaSource

为了更深入地了解KafkaSource,我决定从源码层面进行剖析。首先,我们需要明确几个关键概念:

- ConsumerGroup:消费者组的概念保证了消息的分区消费,从而提升整体吞吐量。

- Offset管理:KafkaSource会定期将消费偏移量存储到Flink的状态后端,确保任务失败时可以从上次的位置继续消费。

- Partition Discovery:动态发现Kafka中的新分区,支持灵活扩展。

接下来,我们来看一下KafkaSource的核心类结构。主要涉及以下几个部分:

- KafkaSourceBuilder:用于构建KafkaSource实例,提供了灵活的配置选项。

- KafkaPartitionSplitEnumerator:负责分配Kafka分区给不同的并行子任务。

- KafkaPartitionSplitReader:实际读取Kafka数据的逻辑实现。

三、实践分享:我的踩坑经历

在实际项目中应用Flink KafkaSource时,我也遇到了不少挑战。例如,如何正确设置并行度以匹配Kafka分区数?如果Kafka集群扩容导致分区增加,Flink任务是否能够自动适配?经过多次试验与调试,我总结出以下几点经验:

- 合理规划Kafka分区数与Flink任务的并行度,避免资源浪费或性能瓶颈。

- 启用Flink的checkpoint机制,确保任务失败后的快速恢复。

- 定期监控KafkaSource的运行状态,及时调整参数以应对流量波动。

四、未来展望:Flink与Kafka的无限可能

随着大数据技术的不断发展,Flink与Kafka的结合将会在更多场景中发挥重要作用。无论是实时数据分析、日志采集还是物联网设备监控,Flink KafkaSource都展现出了卓越的性能与稳定性。作为一名技术人,我期待着未来能够见证更多创新的应用案例。

发表评论 取消回复