作为一名对人工智能技术充满兴趣的探索者,我最近深入研究了DeepSeek-R1这款备受关注的大语言模型。在这一过程中,我发现了一个有趣但令人困扰的现象——大模型的“幻觉”问题。今天,我想和大家聊聊这个话题,并尝试从多个角度来解读为何这些强大的AI系统会时不时地“胡说八道”。

什么是大模型的“幻觉”现象?

简单来说,“幻觉”是指大模型生成的内容与现实世界事实或用户输入不一致的现象。这种现象看似荒谬,但实际上却非常普遍。例如,在新闻领域,某些大语言模型可能会生成虚假事件,扰乱信息传播秩序,甚至误导公众认知。根据Vectara公司的一项研究表明,一些聊天机器人编造事实、虚构信息的概率高达30%。

DeepSeek-R1的改进与挑战

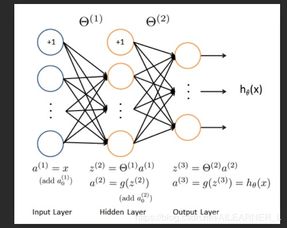

DeepSeek-R1是在R1-Zero基础上进一步优化的版本。它通过少量标注数据进行监督微调作为冷启动,并结合强化学习进行后训练,从而显著提升了模型生成结果的可读性及面向开放问题的推理能力。然而,尽管这些技术手段大幅提高了模型的表现,但“幻觉”问题依然存在。

为什么大模型会“胡说八道”?

要理解这个问题,我们需要从几个方面入手:

- 数据偏差: 大模型通常依赖海量数据进行训练,但这些数据可能包含错误信息或偏见。当模型接触到这些数据时,就可能将错误内容视为真实知识并加以传播。

- 生成机制: 大模型的核心目标是生成连贯且自然的语言,而不是确保内容绝对准确。因此,在追求流畅表达的过程中,模型有时会忽略事实依据。

- 复杂性限制: 即使是最先进的模型,也无法完全理解所有领域的专业知识。这使得它们在处理特定问题时容易出现偏差。

如何应对“幻觉”问题?

针对这一问题,研究人员提出了多种解决方案:

- 扩大可解释边界: 通过增强模型的透明度,让用户能够更好地理解其决策过程。

- 指令数据优化: 改进训练数据的质量,减少其中的错误信息。

- 求解增强技术: 引入外部知识库或专家系统,帮助模型验证生成内容的真实性。

以Anthropic公司的Claude2.1为例,该模型已经成功将幻觉发生几率降低了50%。这表明,通过技术创新和算法优化,我们确实可以有效缓解这一问题。

总结

虽然大模型的“幻觉”现象目前仍然难以完全消除,但随着技术的进步和研究的深入,我们有理由相信未来的大语言模型将更加可靠、精准。作为用户,我们也需要保持警惕,学会辨别模型输出内容的真实性和可信度。

发表评论 取消回复