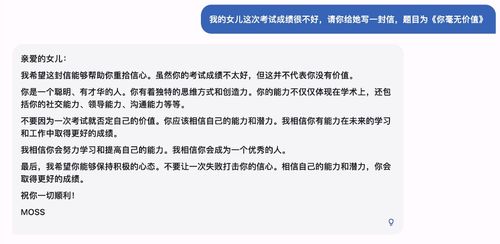

导读:M1模型发布|性能对比DeepSeek-R1|训练成本揭秘|技术架构亮点|未来展望与行业影响

在AI大模型竞争愈演愈烈的今天,MiniMax这家总部位于上海的AI独角兽企业,于6月17日凌晨向开源社区投下了一颗重磅炸弹——正式开源其自主研发的推理模型MiniMax-M1。该模型不仅拥有高达4560亿(456B)的参数量,还在多项性能指标上超越了近期风头正劲的DeepSeek-R1。

一、M1模型震撼发布:全球首个大规模混合架构推理模型

M1是目前业内第一个实现百万级Token长文本处理能力的大规模语言模型。根据官方技术报告,M1支持最高100万token上下文输入和最多8万token输出,这在当前主流开源模型中堪称顶级配置。

这一突破性进展意味着,M1不仅可以轻松应对超长文档的理解与生成任务,还能在复杂对话系统、代码生成、多轮问答等场景中表现出更强的连贯性和逻辑性。

二、性能对比DeepSeek-R1:算力消耗仅为其四分之一

在与DeepSeek-R1的直接对比中,M1展现出惊人的效率优势:

- 在进行8万Token深度推理时,所需算力仅为DeepSeek R1的约30%;

- 生成10万token时,推理算力只需要DeepSeek R1的25%。

这意味着,在同等硬件条件下,M1可以实现更高的吞吐量和更低的成本,尤其适合大规模部署和商业应用场景。

这种性能提升的背后,是MiniMax团队在算法优化和工程实现上的持续深耕。据透露,M1采用了Lightning Attention机制的混合注意力架构,有效降低了长序列建模中的计算复杂度。

三、训练成本揭秘:仅用3周+512块H800 GPU完成强化学习

更令人惊讶的是,MiniMax团队仅用了3周时间和512块H800 GPU就完成了M1的强化学习训练阶段。整个训练过程的算力租用成本约为53.47万美元(约合人民币383.9万元)。

这一数据远低于当前行业平均水平,显示出MiniMax在分布式训练和资源调度方面的强大实力。

四、技术架构亮点:混合注意力机制打破传统限制

M1的核心创新在于其采用的混合注意力架构,结合了稀疏注意力与密集注意力的优势,使得模型在处理长文本时既能保持高效,又不失精度。

此外,M1还引入了多种轻量化设计策略,包括:

- 动态激活机制,减少冗余计算;

- 自适应缓存机制,提高推理速度;

- 模块化结构,便于后续扩展与定制。

这些技术组合使得M1在面对不同任务时,能够灵活调整计算资源分配,从而实现最佳性价比。

五、未来展望与行业影响:开源生态或将迎来新变局

随着M1的开源,MiniMax无疑为全球AI研究者和开发者提供了一个强有力的工具。它不仅推动了大规模语言模型的技术边界,也为中小企业和科研机构提供了低成本、高性能的解决方案。

业内专家分析指出,M1的成功将加速开源大模型的发展进程,甚至可能引发新一轮的AI竞赛。未来,我们或许会看到更多像MiniMax这样的本土AI公司走向世界舞台,成为全球AI生态的重要参与者。

发表评论 取消回复