导读:2017年6月,一篇名为《Attention Is All You Need》的论文横空出世,彻底改变了自然语言处理的世界。转眼间,Transformer模型已经走过了8个春秋。作为一名关注AI领域的自媒体创作者,我也从最初的懵懂到如今对这项技术有了更深的理解。今天,我想和大家分享一下这段旅程。

初识Transformer

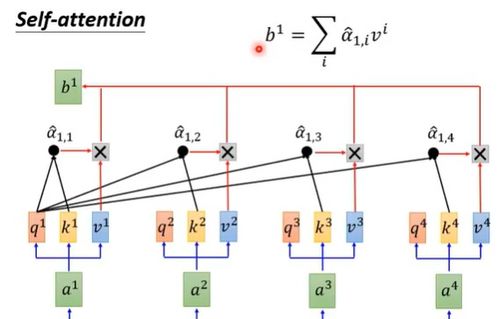

记得那是2017年的夏天,我在知乎上第一次看到有人讨论这篇来自Google和多伦多大学的研究论文。当时我对深度学习还处于入门阶段,对于什么是Self-Attention机制也是一头雾水。但随着越来越多的朋友在朋友圈分享这篇论文,我意识到这可能是AI领域的一次重大突破。

从BERT到GPT:Transformer的爆发

真正让我对Transformer刮目相看的是2018年底BERT的出现。它不仅在多项NLP任务中刷新了SOTA(State of the Art),更让我看到了Transformer的强大潜力。随后,OpenAI推出的GPT系列更是将这一架构推向了高潮。

“Transformer不仅仅是一个模型,它是一种思维方式的革新。”

我的Transformer之路

作为一个非科班出身的技术爱好者,我开始尝试自己动手实现一个小型的Transformer模型。最开始是在Colab上跑通了一个简单的翻译任务,虽然训练过程很慢,但当我看到模型输出的第一句准确翻译时,那种成就感至今难忘。

后来,我还用它做了一些有趣的项目,比如生成诗歌、写歌词,甚至尝试过让模型帮我写文章开头。虽然效果参差不齐,但每一次尝试都让我对Transformer的理解更进一步。

Transformer的未来:不止于NLP

随着时间的推移,Transformer的应用早已超出了自然语言处理的范畴。从图像识别到语音合成,从蛋白质结构预测到自动驾驶,几乎每一个AI领域都能看到它的身影。

我始终相信,Transformer只是一个开始。未来的AI世界,或许会有更多像它一样颠覆性的架构出现。而我们这些热爱AI的人,也将继续在这条路上探索前行。

结语:致敬Transformer

今天是Transformer诞生的第八年,也是我接触AI的第五年。感谢这项技术,让我有机会站在巨人的肩膀上看世界。也希望在未来,我能用自己的方式,为这个领域贡献一份力量。

如果你也对AI感兴趣,不妨从了解Transformer开始。也许你就是下一个改变世界的人。

发表评论 取消回复