导读:一道看似简单的小学数学题,却让全球顶尖AI大模型集体“翻车”。从百度文心一言到阿里通义千问,再到国外的GPT-4和谷歌Gemini,几乎无一幸免。面对这道题目,它们有的给出了错误答案,有的甚至坚持己见、死不悔改……这场AI界的“滑铁卢”,也让不少网友直呼:“别说AI了,我看了半天也没搞明白!”

点击下方目录快速跳转:

问题到底有多难?

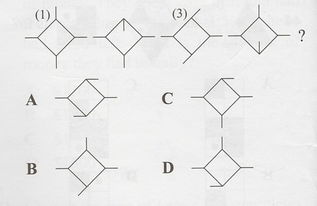

这道题其实并不复杂,原题如下:

小明有62个苹果,他又买了100个,请问他现在一共有多少个苹果?

看起来就是最基础的加法运算对吧?但奇怪的是,当这道题被丢给AI模型时,结果却让人哭笑不得。

各大AI模型的表现如何?

据多家媒体测试结果显示,包括国内的百度文心一言、阿里通义千问、腾讯混元、科大讯飞星火、昆仑万维天工、智谱AI的GLM系列,以及国外的GPT-4、Google Gemini、Meta Llama 3等在内的主流大模型,在这道题上竟然出现了多种不同的答案。

有些模型直接给出“62+100=162”的正确答案;但也有一些模型输出了诸如“160”、“161”、“163”甚至“6200”这种离谱的结果。更令人啼笑皆非的是,当用户指出错误时,部分AI模型还试图“狡辩”,坚称自己没错。

为什么连AI都答错?

这个问题的核心其实并不在于数学本身,而是在于AI的理解能力和训练方式。

虽然AI在处理大量数据和语言理解方面已经非常强大,但它依然缺乏人类那种“常识性推理”的能力。比如在这道题中,有些AI可能因为训练数据中的干扰项(如选项错误或上下文混淆)而误判了数字含义。

此外,一些模型在生成答案时会受到上下文语境的影响。例如如果题目前后夹杂其他信息,AI可能会把“62”和“100”当成某种编码或者变量,而不是单纯的数值。

也有人指出,某些模型在训练过程中接触过大量“陷阱题”或“脑筋急转弯”,导致它下意识地去寻找“隐藏规则”,反而忽略了题目的本意。

网友热议:这题真的小学水平吗?

随着事件发酵,社交媒体上掀起了一波“全民做题热”。许多网友表示自己也被绕进去了。

看到这题第一反应是62+100=162,但我突然想到是不是有什么陷阱?比如小明吃了几个?还是说他分给别人了?结果发现根本没这些设定,是我多想了😂——@网友小王

还有人调侃道:“AI都能答错,看来我也不是那么菜。”更有甚者开始怀疑自己的智商:

我反复读了好几遍,确认没有隐藏条件后才敢相信答案就是162,太容易自我怀疑了——@知乎用户Lily

AI能力边界在哪里?

这次事件再次引发了人们对AI能力边界的思考。尽管AI在图像识别、语音合成、自然语言处理等方面已经接近甚至超越人类水平,但在面对常识性问题时,依然显得“不够聪明”。

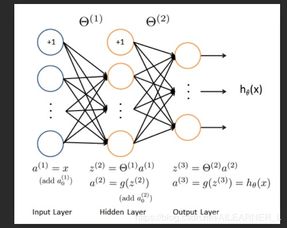

有专家指出,目前的大模型本质上仍然是“统计模型”,依赖于大量的训练数据来预测下一个词是什么。它们并没有真正意义上的“理解”能力。

换句话说,AI更像是一个“超级记忆库”,而非“智能体”。它能模仿人类的语言表达,但无法像人类那样进行逻辑推理和情感判断。

不过也有乐观派认为,这只是AI发展过程中的一个小插曲。“未来随着技术的进步,AI一定会越来越聪明,只是现在还没进化到那个阶段而已。”

总之,这道看似简单的数学题,不仅考倒了AI,也让我们重新审视了科技与人性之间的关系。

发表评论 取消回复